Je rond zelf de data van GFS elke keer af op drie graden, totaal onnodig en uiteraard funest voor een objectieve analyse. Op zo'n manier zal je altijd een grotere afwijking vinden dan dat er in werkelijkheid is

Die methode is heel bewust gekozen, omdat ik van mening ben dat een grootschalig model als GFS is, niet in staat is om voor plaats X een exacte Tx / Tn te berekenen.

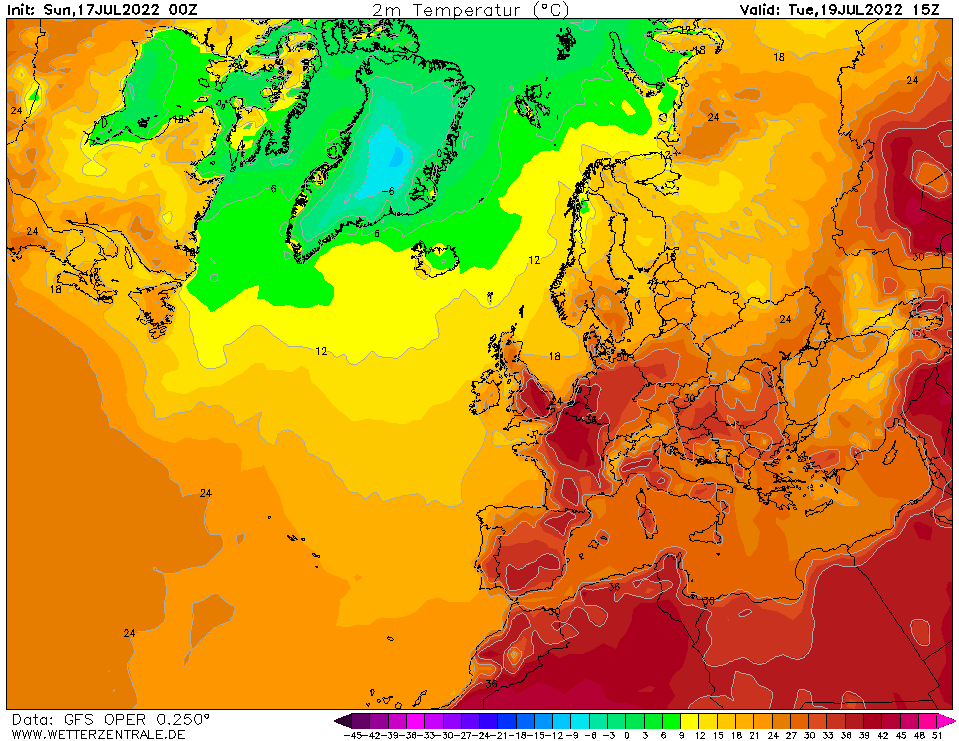

Dus werk ik met de temperatuur categorieën zoals die onderaan de T2m kaarten van GFS te vinden zijn (zie onderstaand voorbeeld) en lees ik daarvan de pixel uit voor de gekozen plaats (in mijn geval Leiden en De Bilt).

Tevens wordt er niet naar één run gekeken, maar naar 15 runs voor elke dag en daar komt een gemiddelde uit.

Die gemiddelden worden uiteindelijk weer geverifieerd met de werkelijkheid om zodoende tot een zo betrouwbaar mogelijk rekenmodel te komen.

Als je volgens ziet dat het rekenmodel loopt sinds juli 2013 (bijna 9 jaar aan data inmiddels, op basis van 2 GFS runs (00z en 12z) per dag en dat 365 dagen per jaar) en de gemiddelde afwijking voor de Tx is -1°C (ofwel, GFS zit gemiddeld 1 graad te laag) dan denk ik niet dat er gesproken kan worden van een grote afwijking.

Daarnaast ben ik zelf altijd de eerste die kritisch is als er dingen niet kloppen.

Ik schreef gisteren al dat GFS voor juli 2022 een afwijking heeft van 0,1°C (wat tot en met gisteren zelfs is opgelopen tot 0,3°C) en dat dit een flinke afwijking is ten opzichten van de hele dataset.

Wel is het een grote overeenkomst met juli 2018, toen de gemiddelde afwijking 0,0°C was.

Het gaat mij er niet om dat men niet ook kritisch mag zijn op GFS, het gaat mij er vooral om dat GFS vaak wordt weggezet als een 'debiel model', terwijl EC geen kwaad kan doen.

Kijk nog eens naar de draai die EC de laatste 3 dagen gemaakt heeft, maar daar hoor je niemand over en als ik er dan over bericht, volgt er gewoon geen reactie, want ja, EC is heilig: